Исследование показывает, что ChatGPT превзошел врачей в качестве ответов на вопросы пациентов

В наши дни ChatGPT является горячей темой для обсуждений, некоторые специалисты поддерживают постоянно развивающуюся технологию, основанную на искусственном интеллекте, а некоторые призывают с осторожностью относиться к тому, как и где ее следует использовать. Новое исследование показало, что по сравнению с врачами-людьми ChatGPT более чуткий и дает более качественные ответы на реальные вопросы о здоровье, поднимая вопрос: можно ли заменить врачей?

Виртуальное здравоохранение получило популярность в разгар пандемии COVID-19 как способ предоставить людям доступ к медицинским работникам, пока они находятся в изоляции.

Но рост виртуального здравоохранения во время пандемии создал дополнительную нагрузку на врачей, которые увидели увеличение количества электронных сообщений пациентов.

Это побудило исследователей из Калифорнийского университета (UC) в Сан-Диего задуматься о роли ИИ, в частности ChatGPT, в медицине. Они хотели знать, может ли ChatGPT точно отвечать на вопросы, которые пациенты задают своим врачам.

«Возможно, ChatGPT сможет сдать медицинский экзамен на получение лицензии, — сказал соавтор исследования доктор Дэйви Смит, врач и профессор Медицинской школы Калифорнийского университета в Сан-Диего, — но прямые ответы на вопросы пациентов, точные и чуткие, — это совсем другое дело».

Чтобы получить большую и разнообразную выборку, исследовательская группа обратилась к Reddit AskDocs (r/AskDocs), в котором более 480 000 участников публикуют медицинские вопросы, на которые отвечают лицензированные, проверенные медицинские работники.

Исследователи случайным образом отобрали 195 уникальных вопросов, передали в ChatGPT (версия 3.5) и попросили его сгенерировать ответ. Три лицензированных медицинских работника оценивали каждый вопрос и соответствующий ответ, не зная, исходил ли он от врача или от ChatGPT.

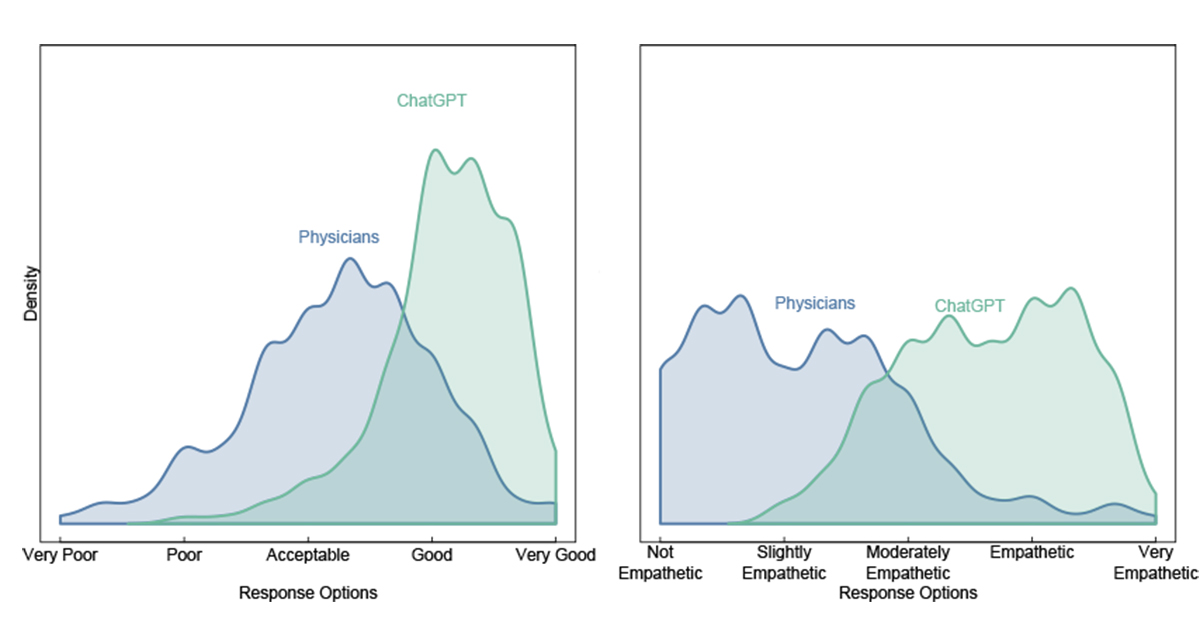

Оценщиков сначала спросили, какой ответ был «лучше». Затем они должны были оценить качество предоставленной информации (очень плохое, плохое, приемлемое, хорошее или очень хорошее) и эмпатию или манеру поведения (не эмпатическая, слегка эмпатическая, умеренно эмпатическая, эмпатическая, очень эмпатическая). Оценщики предпочли ответы ChatGPT в 79% случаев.

«Сообщения ChatGPT содержали детализированную и точную информацию, которая часто затрагивала больше аспектов вопросов пациентов, чем ответы врачей», — сказала соавтор исследования Джессика Келли.

Также было обнаружено, что ChatGPT обеспечивает более качественные ответы. Ответы «хорошо» или «очень хорошо» встречались в 3,6 раза чаще для ChatGPT, чем для врачей (ChatGPT 78,5% по сравнению с врачами 22,1%). И ИИ был более чутким. «Чуткие» или «очень чуткие» ответы были в 9,8 раз чаще для ChatGPT, чем для врачей (ChatGPT 45,1% по сравнению с врачами 4,6%).

Это не означает, что врачей можно заменить, говорят исследователи; им нужно использовать ChatGPT как инструмент обучения для улучшения своей практики.

«Хотя наше исследование противопоставило ChatGPT врачам, окончательное решение не заключается в том, чтобы полностью отказаться от врачей», — сказал соавтор исследования Адам Поляк. «Вместо этого врач, использующий ChatGPT, является ответом на лучший и чуткий уход».

Исследователи говорят, что инвестиции в ChatGPT и другие ИИ положительно повлияют на здоровье пациентов и работу врачей.

Исследование было опубликовано в журнале JAMA Internal Medicine.