Искусственный интеллект Google выявляет когнитивный сбой человека

Людям легко принять складную речь за умную мысль.

Когда вы читаете предложение, подобное этому, ваш прошлый опыт заставляет вас поверить, что оно написано мыслящим, думающим человеком. И в этом случае это действительно так. Но в наши дни некоторые предложения, которые кажутся удивительно похожими на человеческие, на самом деле генерируются системами искусственного интеллекта, которые были обучены на огромном количестве человеческого текста.

Люди настолько привыкли считать, что беглая и грамотная речь исходит от мыслящего человека, что доказательства обратного могут быть трудны для понимания.

Как люди могут ориентироваться на этой относительно неизведанной территории? Из–за стойкой тенденции ассоциировать свободное выражение с беглым мышлением естественно – но потенциально ошибочно — думать, что если модель искусственного интеллекта может свободно выражать себя, это означает, что она также думает и чувствует, как люди.

В результате, возможно, неудивительно, что бывший инженер Google недавно заявил, что система искусственного интеллекта Google LaMDA обладает чувством собственного достоинства, поскольку она может красноречиво генерировать текст о своих предполагаемых чувствах.

Это событие и последующее освещение в средствах массовой информации привели к появлению ряда справедливо скептических статей и сообщений о том, что вычислительные модели человеческого языка являются разумными, то есть способными мыслить, чувствовать и переживать.

Вопрос о том, что означало бы для модели искусственного интеллекта быть разумной, на самом деле довольно сложен, и наша цель в этой статье — не решать его. Но как исследователи языка, мы можем использовать нашу работу в области когнитивной науки и лингвистики, чтобы объяснить, почему людям слишком легко попасть в когнитивную ловушку, предполагая, что существо, которое может свободно использовать язык, является сознательным или разумным.

Использование искусственного интеллекта для создания человекоподобного языка

Текст, сгенерированный с помощью таких моделей, как LaMDA от Google, может быть трудно отличить от текста, написанного человеком.

Это впечатляющее достижение является результатом десятилетней программы по созданию моделей, генерирующих грамматический, осмысленный язык.

Ранние версии, датируемые по крайней мере 1950-ми годами, известные как n-граммные модели, просто подсчитывали вхождения определенных фраз и использовали их, чтобы угадать, какие слова, вероятно, будут встречаться в определенных контекстах.

Например, легко понять, что “арахисовое масло и джем”* — более вероятная фраза, чем “арахисовое масло и ананасы”. Если у вас достаточно текста (на английском языке), вы будете видеть фразу “арахисовое масло и джем” снова и снова, но, возможно, никогда не увидите фразу “арахисовое масло и ананасы”.

Сегодняшние модели, наборы данных и правил, приближенные к человеческому языку, отличаются от этих ранних попыток несколькими важными способами. Во-первых, они проходят обучение практически по всему Интернету.

Во-вторых, они могут изучать отношения между словами, которые находятся далеко друг от друга, а не только между соседними словами. В–третьих, они настраиваются огромным количеством внутренних “регуляторов” — их так много, что даже инженерам, которые их проектируют, трудно понять, почему они генерируют одну последовательность слов, а не другую.

Однако задача моделей остается той же, что и в 1950-х годах: определить, какое слово, скорее всего, будет следующим. Сегодня они настолько хорошо справляются с этой задачей, что почти все предложения, которые они генерируют, кажутся плавными и грамматическими.

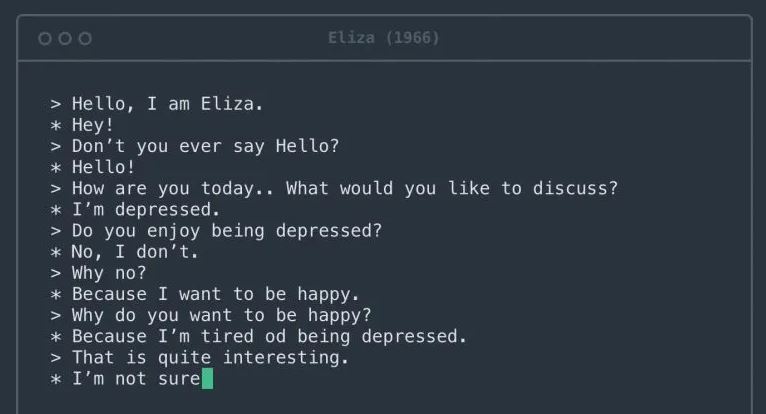

* Хей!

> Ты никогда не говоришь Привет?

* Привет!

> Как у тебя дела сегодня… Что бы ты хотел обсудить?

* Я в депрессии.

> Нравится ли тебе быть в депрессии?

* Нет, я не знаю.

> Почему нет?

* Потому что я хочу быть счастливым.

> Почему ты хочешь быть счастливым?

* Потому что я устал от депрессии.

> Это довольно интересно.

* Я не уверен».

Первой компьютерной системой, которая вовлекала людей в диалог, была программа под названием Eliza, созданная более полувека назад. Фото: Rosenfeld Media

Арахисовое масло и ананасы?

Мы попросили большую языковую модель GPT-3 завершить предложение “Арахисовое масло и ананасы ___”.

Она сказала: “Арахисовое масло и ананасы — отличное сочетание. Сладкий и пикантный вкус арахисового масла и ананаса прекрасно дополняют друг друга.”

Если бы человек сказал это, можно было бы сделать вывод, что он попробовал арахисовое масло и ананас вместе, составил мнение и поделился им с читателем.

Но как GPT-3 придумала этот абзац? Путем создания слова, соответствующего предоставленному нами контексту. А потом еще одного. А потом еще одного. Модель никогда не видела, не трогала и не пробовала ананасы – она просто обработала все тексты в Интернете, в которых они упоминаются.

И все же чтение этого абзаца может привести человеческий разум – даже разум инженера Google – к представлению GPT-3 как разумного существа, способного рассуждать о блюдах с арахисовым маслом и ананасами.

Большие языковые модели искусственного интеллекта могут свободно общаться. Однако у них нет общего посыла для общения, поэтому их фразы часто следуют общепринятым литературным тропам, извлеченным из текстов, на которых они обучались.

Например, если задать тему “природа любви”, модель может генерировать предложения о вере в то, что любовь побеждает все. Человеческий мозг заставляет наблюдателя интерпретировать эти слова как мнение модели по данной теме, но это просто правдоподобная последовательность слов.

Человеческий мозг запрограммирован на то, чтобы угадывать намерения, стоящие за словами. Каждый раз, когда вы вступаете в разговор, ваш разум автоматически создает ментальную модель вашего собеседника. Затем вы используете слова, которые они говорят, чтобы заполнить модель с целями, чувствами и убеждениями этого человека.

Процесс перехода от слов к ментальной модели происходит плавно и запускается каждый раз, когда вы получаете полноценное предложение. Этот когнитивный процесс экономит вам много времени и усилий в повседневной жизни, значительно облегчая ваши социальные взаимодействия.

Однако в случае с системами искусственного интеллекта это дает осечку – построение ментальной модели из воздуха.

Еще немного исследований может выявить серьезность этой осечки.

Рассмотрите следующую подсказку: “Арахисовое масло и перья прекрасно сочетаются друг с другом, потому что ___”.

GPT-3 продолжила: “Арахисовое масло и перья прекрасно сочетаются друг с другом, потому что у них обоих ореховый вкус. Арахисовое масло также гладкое и кремообразное, что помогает компенсировать текстуру перьев.”

Текст в этом случае такой же складный, как в нашем примере с ананасами, но на этот раз модель говорит что-то явно менее разумное. Начинаешь подозревать, что GPT-3 на самом деле никогда не пробовала арахисовое масло и перья.

Приписывание интеллекта машинам, отрицание его у людей

Печальная ирония заключается в том, что та же когнитивная предвзятость, которая заставляет людей приписывать GPT-3 человечность, может заставить их бесчеловечно относиться к реальным людям.

Социокультурная лингвистика – изучение языка в его социальном и культурном контексте – показывает, что предположение о чрезмерно тесной связи между свободным выражением и свободным мышлением может привести к предвзятому отношению к людям, которые говорят по-другому.

Например, люди с иностранным акцентом часто воспринимаются как менее умные. Аналогичные предубеждения существуют в отношении носителей диалектов, которые не считаются престижными, в отношении глухих людей, использующих языки жестов, и людей с нарушениями речи, такими как заикание.

Эти предубеждения глубоко вредны, часто приводят к расистским и сексистским предположениям и снова и снова доказывают свою необоснованность.

Свободное владение языком само по себе не означает человечности.

Станет ли ИИ когда-нибудь разумным? Этот вопрос требует глубокого рассмотрения, и действительно, философы размышляли над ним десятилетиями. Однако исследователи определили, что вы не можете просто доверять языковой модели, когда она говорит вам, что она чувствует.

Слова могут вводить в заблуждение, и слишком легко принять складную и беглую речь за умную мысль.

* арахисовое масло и джем — Peanut butter and jelly sandwich – бутерброд с арахисовой пастой и джемом, ставший классикой Американской культуры.

Авторы:

- Кайл Маховальд, доцент лингвистики, Техасский университет в Остинском колледже гуманитарных наук

- Анна Иванова, кандидат наук в области мозга и когнитивных наук, Массачусетский технологический институт